Les emails professionnels, accessibles aux ex‑salariés ? Ce que dit l’arrêt du 18 juin 2025

Introduction

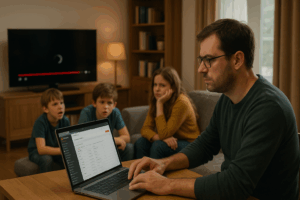

Un simple départ de salarié, autrefois réglé en quelques clics, devient aujourd’hui un casse-tête juridique. Depuis l’arrêt de la Cour de cassation du 18 juin 2025, les emails professionnels sont officiellement considérés comme des données personnelles. Conséquence : l’entreprise doit se conformer au RGPD, même après le départ d’un collaborateur. Et spoiler : non, on ne peut plus rediriger ses mails comme avant.

Arrêt du 18 juin 2025 : ce qu’il change

La Cour de cassation (arrêt n° 23-19.022) a jugé que les emails professionnels sont des données personnelles, désormais protégées par le RGPD. Cela inclut :

- Le contenu des messages ;

- Les métadonnées (date, heure, destinataire, etc.).

L’ex-salarié peut donc demander l’accès à sa messagerie même après son départ.

Comment cet accès doit-il se concrétiser ?

Les employeurs ont désormais l’obligation de répondre aux demandes d’accès sous un mois (voire trois en cas de complexité). Ils doivent fournir :

- Le contenu des emails ;

- Les métadonnées (horodatage, destinataires…) ;

sauf si ces éléments portent atteinte aux droits d’un tiers (secret des affaires, vie privée…)

Jusqu’où peut-on aller ?

Le salarié n’a pas nécessairement le droit à la copie brute de l’email – un tableau synthétique peut suffire. Toutefois, en cas de refus complet, l’employeur s’expose à des sanctions financières via les prud’hommes ou la CNIL .

Impacts opérationnels pour les entreprises

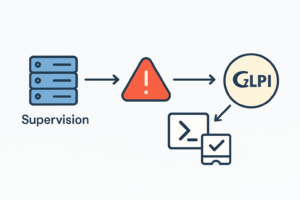

Pour se conformer, l’entreprise doit :

- Mettre en place une politique claire de rétention des emails,

- Prévoir dès l’arrivée du salarié les modalités de conservation et restitution en cas de départ,

- Documenter les traitements dans le registre RGPD,

- Adopter des procédures efficaces d’extraction ou de synthèse des données.

Rediriger les mails vers un collègue : (presque) toujours interdit

Même dans le cadre du départ d’un collaborateur, tu ne peux pas rediriger ses mails vers un autre collègue sans encadrement strict. C’est une atteinte au secret des correspondances.

Ce qui est interdit :

- Redirection automatique permanente vers un collègue ;

- Réponse automatique qui se fait passer pour l’ex-salarié ;

- Conservation d’un alias

prenom.nom@...sans mention claire du départ.

Ce qui est autorisé :

- Mise en place d’une réponse automatique claire mentionnant le départ ;

- Redirection temporaire, max 1 mois, à condition que le salarié ait été informé avant son départ et que ce soit documenté dans le registre RGPD ;

- Boîte fonctionnelle ou partagée sans nom de personne (

support@...).

Comment gérer concrètement une départ dans M365 ?

- Bloquer l’accès au compte, sans supprimer la boîte (conservation des données) ;

- Interdire la redirection automatique vers un autre utilisateur ;

- Configurer une réponse automatique claire ;

- Appliquer une règle de rétention via Microsoft Purview ;

- Supprimer le compte une fois la période de rétention expirée, selon la politique interne.

Obligation d’accès à ses emails pour l’ex-salarié

Si un ex-collaborateur demande l’accès à ses mails, l’entreprise a 1 mois pour répondre (voire 3 en cas de complexité). Elle doit fournir :

- Le contenu des emails ;

- Les métadonnées associées.

⚠️ Mais : certaines données peuvent être occultées si elles concernent la vie privée d’autrui, le secret des affaires, etc.

En conclusion

Le départ d’un salarié doit être préparé comme une opération à part entière :

- Sécurité des données,

- Respect du RGPD,

- Continuité du service,

- Communication claire vers les clients.

En tant qu’admin ou DSI, tu dois avoir une procédure d’offboarding précise, documentée, conforme et humaine. La jurisprudence de 2025 ne laisse plus de place à l’improvisation.

👇 Et chez vous, comment vous gérez les départs ? Avez-vous adapté vos pratiques à la lumière du RGPD et des dernières décisions ? Partagez vos retours et n’hésitez pas à commenter !